La règlementation efficace de Meta est « une question de vie ou de mort »

Pat de Brún, directeur du programme d’Amnistie internationale consacré à l’obligation de rendre des comptes pour les géants technologiques

Le rôle catastrophique de Meta dans les persécutions infligées à la population rohingya doit rappeler avec force aux autorités de régulation de l’Union européenne qu’une règlementation efficace des géants technologiques est une question de vie ou de mort.

Le 25 août marque le sixième anniversaire des atrocités subies par les Rohingyas – mais aussi l’entrée en vigueur de dispositions clés de la loi sur les services numériques, la nouvelle règlementation historique de l’Union européenne qui régit l’industrie des géants technologiques. Ce texte de loi contient des restrictions importantes pour ces puissantes entreprises, notamment des normes minimales de sécurité pour les systèmes de recommandation de contenus fondés sur les algorithmes. S’il est dûment appliqué, il a la capacité de prévenir ou d’atténuer la répétition de ce qui s’est passé pour les Rohingyas.

Je n’ai absolument aucun doute sur le fait que les dangereux algorithmes de Facebook – conçus pour favoriser l’« engagement » et les profits des entreprises à tout prix – ont attisé les flammes de la haine, contribuant finalement à la violence généralisée et au déplacement forcé de la majeure partie de la population rohingya du Myanmar vers le Bangladesh voisin, il y a six ans.

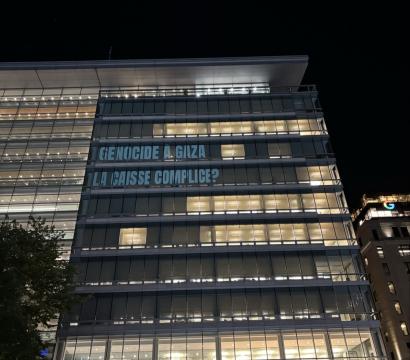

Pendant les années et les mois qui ont précédé ces atrocités en 2017, Facebook est devenue la caisse de résonance de la haine et de l’incitation à la violence, ciblant ce groupe minoritaire persécuté depuis longtemps. Tout cela dans un contexte où « Facebook [était] l’Internet », selon une enquête de l’ONU.

Qui plus est, les « Facebook Papers », divulgués par la lanceuse d’alerte Frances Haugen en 2021, ont mis en lumière les rouages internes de l’entreprise – une avalanche de révélations toutes plus ahurissantes les unes que les autres. Ces éléments ne laissent guère de place au doute : Meta savait depuis longtemps que ses algorithmes sont responsables de la prolifération disproportionnée des discours haineux et de la désinformation, et que son modèle économique alimente de graves préjudices dans la vie réelle, particulièrement parmi les populations touchées par des conflits.

Il était évident, même après avoir eu vent de ces informations, que l’entreprise allait maintenir son approche habituelle. Les fuites ont également révélé que le discours de Meta au sujet de son rôle soi-disant passif au Myanmar n’était pas crédible. Face à cette prise de conscience, Amnistie internationale a décidé d’ouvrir une enquête sur le rôle de l’entreprise dans le nettoyage ethnique des Rohingyas.

L’an dernier, Amnistie a publié les conclusions de cette enquête. Elle a révélé que Meta avait gravement minimisé la vraie nature et l’ampleur de sa contribution aux souffrances des Rohingyas et conclu que, loin d’être un acteur neutre confronté à une crise sans précédent, Meta avait activement contribué aux horreurs subies par les Rohingyas.

Nous pouvons désormais conclure avec assurance que les algorithmes qui alimentent la plateforme Facebook ont favorisé la propagation de la haine et de la violence, comme une traînée de poudre, promu de manière proactive des contenus incitant à la violence et donné une résonance disproportionnée aux contenus les plus incendiaires en amont des horreurs de 2017.

Facebook fut un catalyseur des violences et des atrocités à venir.

Tandis que ses algorithmes attisaient les flammes de la haine, le personnel de Meta ignorait les multiples avertissements émanant de défenseur·e·s des droits humains, d’universitaires et d’autres experts. Entre 2012 et 2017, la direction de Meta a reçu au moins 15 avertissements directs affirmant que la plateforme Facebook risquait de contribuer à l’éclatement d’une violence généralisée contre les Rohingyas.

Guère de place au doute : Meta ayant contribué à de graves violations des droits humains, elle doit assumer sa responsabilité, au regard des normes internationales et du droit international en matière de droits humains, d’accorder réparation aux Rohingyas.

Nous demandons que les Rohingyas soient indemnisés et que Meta prenne des mesures afin de veiller à ce que cela ne se reproduise pas en changeant son modèle commercial – qui tire profit de la prolifération de la haine.

Nous avons présenté nos conclusions à Meta, des dizaines de milliers de personnes ont rejoint notre campagne et pourtant, jusqu’à présent, rien ou presque n’a changé. Le modèle commercial toxique de Meta demeure tourné vers l’engagement avant tout.

Meta, l’une des entreprises les plus riches de la planète, a même refusé la modeste requête de la communauté de verser un million de dollars à titre de réparation partielle pour un fonds d’éducation destiné aux jeunes Rohingyas déplacés qui luttent pour réaliser leur potentiel dans les camps de réfugiés tentaculaires de Cox’s Bazar. Elle ne s’engage pas, selon ses termes, dans des « activités philanthropiques ». Ce n’était pas une demande de charité : il s’agit du manquement de Meta à ses responsabilités en matière de droits humains.

Malgré l’énorme pouvoir et l’immense richesse dont dispose Meta, la communauté rohingya refuse de renoncer à tout espoir et reste déterminée à obtenir que l’entreprise rende des comptes. Amnistie internationale se tiendra à ses côtés jusqu’à ce que justice soit rendue.

Aujourd’hui, l’entrée en vigueur de la Loi sur les services numériques marque une avancée historique et cruciale dans les efforts visant à réglementer l’activité des géants de la technologie. Pourtant, l’enjeu reste de taille. Il faut une application et une mise en œuvre rigoureuses pour que cette loi tienne ses promesses et protège les citoyen·ne·s des pratiques commerciales destructrices des grandes entreprises technologiques.

La Commission européenne et les États membres de l’UE ont un rôle central à jouer pour garantir qu’elle ne se résume pas à un simple bout de papier. Les législateurs de l’UE doivent tirer les leçons du passé et s’attacher à faire en sorte que le rôle de Meta dans la crise des Rohingyas ne se reproduise plus jamais.