Union européenne. La loi sur l’IA doit interdire les technologies dangereuses basées sur l’IA

L’Union européenne (UE) doit interdire les technologies dangereuses basées sur l’intelligence artificielle (IA) dans sa loi sur l’IA, a déclaré Amnistie Internationale le 28 septembre, alors que ce bloc entend finaliser cet automne sa réglementation sur l’IA qui sera la plus exhaustive au monde.

De nombreux États à travers le monde ont déployé des systèmes basés sur l’IA non réglementés pour évaluer des demandes de prestations sociales, surveiller les lieux publics ou déterminer la probabilité qu’une personne commette une infraction. Ces technologies sont souvent présentées comme étant des « solutions techniques » pour des problèmes structurels tels que la pauvreté, le sexisme et la discrimination. Elles utilisent des volumes colossaux de données, souvent sensibles, qui sont injectées dans des systèmes automatisés pour savoir si tel ou tel individu peut recevoir un logement, des prestations sociales, des soins de santé et une éducation – voire si cette personne doit être inculpée d’une infraction.

Or, au lieu de régler des problèmes sociétaux, de nombreux systèmes basés sur l’IA amplifient de façon flagrante le racisme et les inégalités, et perpétuent les atteintes aux droits fondamentaux et la discrimination.

« Ces systèmes ne sont pas utilisés pour améliorer l’accès aux prestations sociales : ils servent à réduire les dépenses. Et quand il existe déjà un racisme et une discrimination systémiques, ces technologies intensifient les préjudices subis par les communautés marginalisées, avec une ampleur et une rapidité accrues, a déclaré Mher Hakobyan, conseiller en matière de plaidoyer à Amnistie Internationale sur la réglementation relative à l’IA.

« Au lieu de se focaliser de façon disproportionnée sur les "menaces existentielles" que crée l’IA, les législateurs·trices européens devraient concevoir des lois qui remédient aux problèmes existants, tels que le fait que ces technologies sont utilisées pour prendre des décisions manifestement discriminatoires qui sapent l’accès aux droits fondamentaux. »

Privés d’aide sociale à l’enfance

En 2021, Amnistie Internationale a rassemblé des informations montrant qu’un système basé sur l’IA utilisé par les autorités fiscales néerlandaises avait procédé à un profilage ethnique des bénéficiaires de l’aide sociale à l’enfance. Cet outil était censé vérifier si les demandes de prestations sociales étaient légitimes ou frauduleuses, mais le système a en fait injustement pénalisé des milliers de parents à faible revenu ou immigrants en les faisant plonger dans un endettement exorbitant et dans la pauvreté.

Batya Brown, qui a été accusée à tort de fraude aux prestations sociales par le système néerlandais d’aide à l’enfance, a déclaré que les autorités fiscales néerlandaises lui ont demandé de rembourser plusieurs centaines de milliers d’euros. Elle s’est retrouvée inextricablement empêtrée dans un imbroglio bureaucratique et financier extrêmement angoissant. Plusieurs années se sont depuis écoulées, mais la justice demeure hors d’atteinte.

« C’était très bizarre. J’ai reçu une lettre indiquant que j’avais à tort perçu une aide sociale à l’enfance. J’ai alors pensé "comment est-ce possible ?". J’avais une petite vingtaine d’années. Je ne savais pas grand-chose au sujet de l’administration fiscale. J’ai dû me plonger dans les démarches administratives. Et j’ai vu que la situation m’échappait totalement. Depuis, on nous a reconnu le statut de victimes de ce que j’appelle le « crime des prestations sociales », et quatre ans après, on continue de nous traiter comme des numéros », a déclaré Batya Brown.

« Le scandale de l’aide sociale à l’enfance aux Pays-Bas doit servir d’avertissement pour les législateurs·trices européens. L’utilisation de systèmes basés sur l’IA pour le contrôle de l’attribution de prestations sociales essentielles peut entraîner des conséquences dévastatrices pour les communautés marginalisées. La notation sociale, le profilage et les systèmes d’évaluation des risques doivent tous être interdits dans la loi sur l’IA, qu’ils soient utilisés pour contrôler les bénéficiaires de prestations sociales, pour « prédire » la probabilité de commission d’une infraction ou pour statuer sur les demandes d’asile », a déclaré Mher Hakobyan.

L’utilisation et l’exportation de systèmes de surveillance intrusifs doivent être interdites

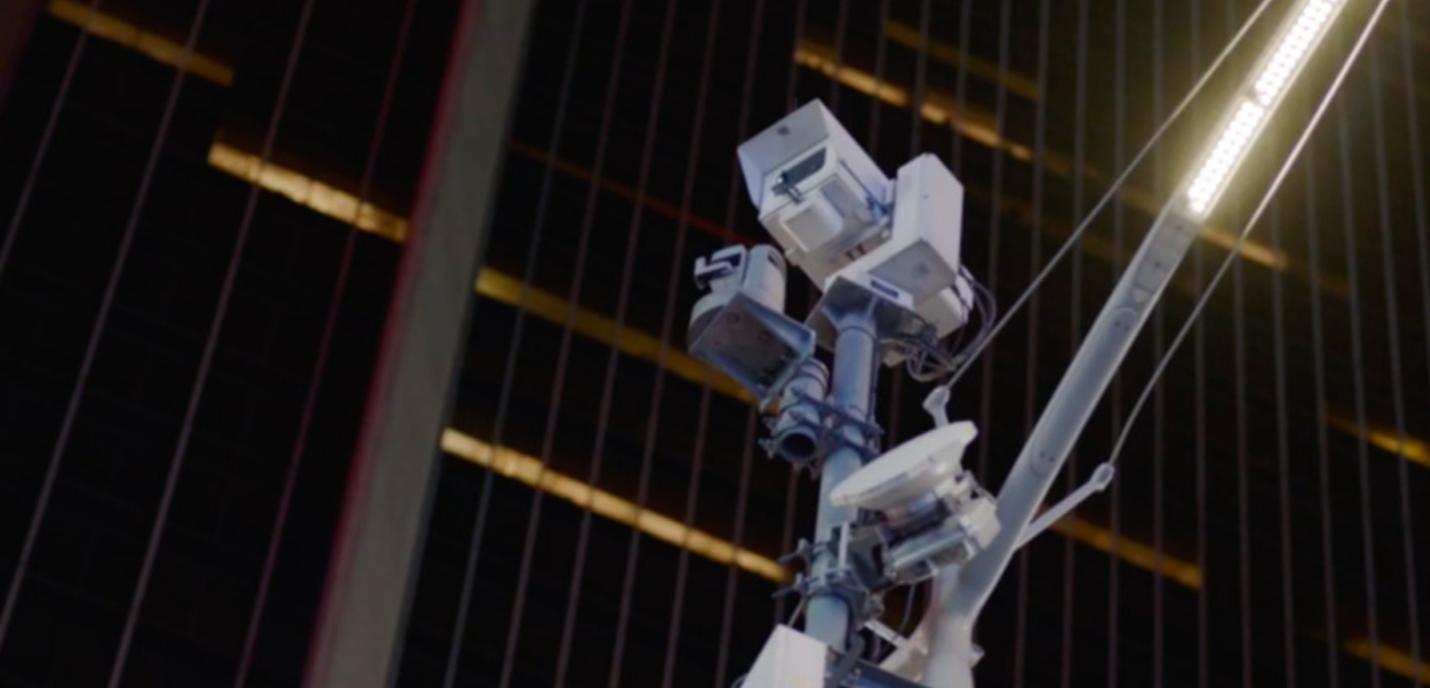

Les systèmes de reconnaissance faciale deviennent un outil de prédilection pour les gouvernements qui, sous prétexte de préserver la « sécurité nationale », cherchent à contrôler de façon excessive les individus au sein de la société. Les agences de l’application des lois déploient ces systèmes dans les lieux publics pour identifier les personnes qui pourraient avoir commis une infraction, malgré le risque d’arrestation injustifiée.

Amnistie Internationale, en tant que membre d’une coalition regroupant plus de 155 organisations, a appelé à l’interdiction totale de la reconnaissance faciale en direct et rétrospective dans les espaces accessibles au public, y compris dans les zones frontalières et autour des centres de détention, par tous les acteurs concernés, sans aucune exception dans l’UE.

Amnistie Internationale a montré, à l’aide des informations qu’elle a réunies, que dans des endroits tels que New York, Hyderabad et les territoires palestiniens occupés (TPO), les dispositifs de reconnaissance faciale accélèrent les systèmes existants de contrôle et de discrimination. Dans les TPO, les autorités israéliennes utilisent la reconnaissance faciale pour surveiller et contrôler les Palestinien·ne·s en restreignant leur droit de circuler librement et leurs possibilités d’exercer leurs droits fondamentaux. Les recherches menées par Amnistie Internationale ont également révélé que des caméras fabriquées par l’entreprise néerlandaise TKH Security font partie du système de surveillance installé dans Jérusalem-Est occupée.

« Outre le fait qu’il leur faut interdire totalement la reconnaissance faciale au sein de l’UE, les législateurs·trices européens doivent également veiller à ce que ces outils ainsi que d’autres technologies très problématiques interdites dans l’UE ne soient pas fabriqués dans le bloc dans le but d’être exportés dans des pays où ils seront utilisés pour commettre de graves violations des droits humains. L’UE et ses États membres ont l’obligation au titre du droit international de veiller à ce que les entreprises soumises à leur droit ne tirent pas profit d’atteintes aux droits humains grâce à l’exportation de technologies utilisées à des fins de surveillance de masse et de maintien de l’ordre à caractère raciste », a déclaré Mher Hakobyan.

Les technologies basées sur l’IA facilitent les atteintes aux droits des personnes migrantes

Les États membres de l’UE recourent de plus en plus à des technologies opaques et hostiles pour faciliter des atteintes aux droits des personnes migrantes, réfugiées ou demandeuses d’asile à leurs frontières.

Les législateurs·trices doivent interdire les systèmes racistes de profilage et d’évaluation des risques qui considèrent les personnes migrantes ou demandeuses d’asile comme des « menaces », ainsi que les technologies prévisionnelles qui sont utilisées pour anticiper les mouvements aux frontières et priver des personnes du droit d’asile.

« À chaque fois que vous passez par un aéroport, à chaque fois que vous traversez une frontière, à chaque fois que vous postulez pour un emploi, vous êtes soumis·e aux décisions de ces modèles. Il n’est pas nécessaire d’en arriver à Terminator ou à Matrix pour considérer qu’il s’agit de menaces existentielles. Il s’agit pour les gens d’une menace existentielle si on les prive de leurs chances d’épanouissement et de leurs moyens de subsistance », a déclaré Alex Hanna, directrice de la recherche au Distributed AI Research Institute (DAIR).

La loi sur l’IA ne doit pas accorder aux géants de la haute technologie le pouvoir de s’autoréglementer

Les géants de la haute technologie ont également effectué un travail de pression pour que des échappatoires soient introduites dans la procédure de classification des risques de la loi sur l’IA, afin que ces entreprises puissent elles-mêmes établir si leurs technologies doivent ou non être classées dans la catégorie « risque élevé ».

« Il est crucial que l’UE adopte une réglementation sur l’IA qui protège et promeuve les droits humains. Le fait d’accorder aux géants de la haute technologie le pouvoir de s’autoréglementer saperait gravement les principaux objectifs de la loi sur l’IA, notamment celui qui porte sur la protection des personnes contre les atteintes aux droits fondamentaux. La solution à ce problème est très simple : il s’agit simplement de revenir à la première proposition de la Commission européenne, qui prévoit très clairement une liste de scénarios où l’utilisation d’un outil basé sur l’IA serait considéré comme étant à haut risque », a déclaré Mher Hakobyan.

Complément d’information

Amnistie Internationale, qui fait partie d’une coalition d’organisations de la société civile menée par le Réseau européen des droits numériques (EDRi), a demandé l’adoption d’une réglementation européenne sur l’intelligence artificielle qui protège et promeuve les droits humains, notamment les droits des personnes en mouvement.

Des négociations trilatérales de haut niveau, appelées trilogues, entre le Parlement européen, le Conseil de l’UE (qui représente les 27 États membres de l’UE) et la Commission européenne doivent avoir lieu en octobre, leur objectif étant l’adoption d’une loi sur l’IA avant la fin de l’actuel mandat européen, en 2024.